Bruxelles propose un règlement pour encadrer l’IA - Acte I

Maud Lambert

Maud Lambert est Avocat au Barreau de Paris. Associée du cabinet Smalt Avocats, elle est en charge de la pratique Technologies, Données personnelles et E-santé.

Elle est également Professeur Expert à aivancity school for technology, business & society

La Commission européenne a présenté le 21 avril 2021 une proposition de règlement visant à encadrer les systèmes d’intelligence artificielle.

Ce texte constitue le tout premier cadre juridique sur l’IA en Europe.

Il a pour ambition de créer un écosystème de confiance destiné à susciter chez les citoyens la confiance nécessaire pour adopter les applications d’IA et donner aux entreprises et aux organismes publics la sécurité juridique pour innover au moyen de l’IA.

Ce texte s’inscrit dans la lignée des contributions récentes de la Commission européenne au développement du numérique via les propositions du Digital Market Act (DMA), du Digital Service Act (DSA), du Data Governance Act et de la Directive Open Data.

La Commission européenne a fait le choix d’un texte sous forme de « règlement » directement applicable, une fois adopté, dans tout État membre dans le but d’établir des normes égales dans l’ensemble de l’Union.

Quels sont les objectifs ?

Les objectifs de ce règlement sont multiples :

- Veiller à ce que les systèmes d'IA mis sur le marché de l'Union et utilisés soient sûrs et respectent la législation existante sur les droits fondamentaux et les valeurs de l'Union ;

- Assurer la sécurité juridique pour faciliter l'investissement et l'innovation dans l'IA ;

- Améliorer la gouvernance et l'application effective de la législation existante sur les droits fondamentaux et les exigences de sécurité applicables aux systèmes d'IA ;

- Faciliter le développement d'un marché unique pour les applications d'IA légales, sûres et dignes de confiance et prévenir la division du marché.

Pour atteindre ces objectifs, la Commission propose une approche réglementaire équilibrée et proportionnée en matière d'IA, qui se limite à la prise en compte d’exigences minimales nécessaires pour faire face aux risques et aux problèmes liés à l'IA sans contraindre ou entraver le développement technologique ou augmenter de manière disproportionnée le coût de la mise sur le marché de solutions d'IA.

Le texte de la proposition est construit sur la base des réflexions et d’analyses menées auprès de l’ensemble des parties prenantes, en particulier les réponses à l’importante consultation publique lancée après la publication par la Commission Européen du Livre blanc sur l’IA en février 2020 (Livre blanc, Intelligence artificielle, COM(2020) 65 final) et les travaux menés depuis 2018 par le High Level Expert Group on Artificial Intelligence (AI HLEG : Groupe composé de 52 experts intégrant des chercheurs, universitaires, représentants de la société civile, groupes de défense des consommateurs, ainsi que des salariés d’entreprise, des conseillers politiques et des experts juridiques) qui a notamment élaboré des lignes directrices sur l’éthique -Lignes directrices en matière d’éthique pour une IA digne de confiance -(en matière d’équité, de sécurité, de transparence), l’avenir du travail et plus largement l’impact sur le respect des droits fondamentaux, notamment sur la vie privée et la protection des données personnelles.

Que prévoit concrètement le texte ?

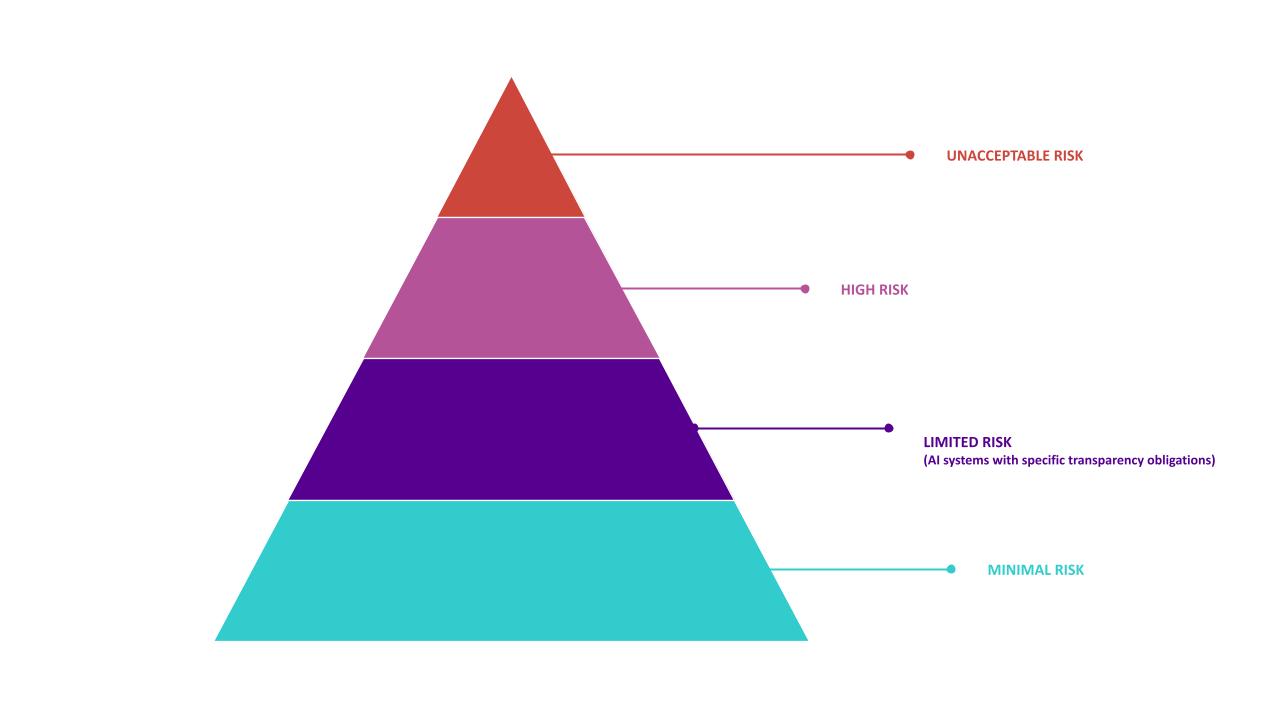

L’encadrement juridique de l’IA proposé s’articule autour d’une approche des systèmes d’IA par les risques.

Plus les risques sont importants plus les règles pour une utilisation sur le marché sont contraignantes.

- Les systèmes d’IA à risque inacceptable : ce sont les systèmes interdits car ils créent une menace évidente pour la sécurité, les moyens de subsistance et les droits des personnes (ex. les systèmes qui manipulent le comportement d’une personne, exploitent les vulnérabilités d’un groupe par des pratiques discriminatoires).

- Les systèmes d’IA à haut risque : ce sont les systèmes d’IA à risque élevé pour la santé, la sécurité ou les droits fondamentaux des personnes physiques, dont une liste sera jointe au texte (ex. application de l'IA dans la chirurgie assistée par robot, logiciel de tri des CV pour les procédures de recrutement, évaluation du crédit qui prive les citoyens de la possibilité d'obtenir un prêt). Ils seront tous évalués avant leur mise sur le marché (marquage CE) et tout au long de leur cycle de vie.

- Les systèmes d’IA à risque limité : ce sont les systèmes tels que les chatbots. Ils seront soumis à des obligations de transparence minimales, destinées à permettre aux personnes interagissant avec le contenu de prendre des décisions éclairées.

- Les systèmes d’IA à risque minimal : ce sont les systèmes ne représentant qu'un risque minimal ou nul pour les droits ou la sécurité des citoyens. Leur utilisation sera libre tels que des jeux vidéo ou des filtres anti-spam.

Il est prévu également un mécanisme de surveillance du marché et d’évaluation des systèmes pour assurer leur conformité ainsi qu’une procédure de reporting des incidents.

Le projet de règlement prévoit un cadre pour soutenir l’innovation en encourageant les autorités nationales à mettre en place des « bacs à sable » réglementaires de l'IA destinés à tester dans un environnement contrôlé des technologies innovantes pendant une durée limitée et à réduire la charge réglementaire pesant sur les les PME et les start-ups.

Enfin, le texte prévoit des sanctions lourdes en cas de non-respect de ces nouvelles exigences pouvant aller jusqu’à 20 millions d’euros ou 6% du chiffre d’affaires.

Les nouvelles règles prévues s'appliqueront aussi bien aux acteurs du secteur public qu'aux entreprises, quelle que soit leur taille, à l'intérieur comme à l'extérieur de l'Union européenne, pour tout système d'IA mis sur le marché dans l'Union ou dont l'utilisation a une "incidence" sur les personnes situées dans l'UE. Les entreprises américaines et chinoises concernées devront ainsi aussi se conformer à ce règlement.

Quand le texte pourrait être applicable ?

D’un point du vue du calendrier, l’adoption de ce texte devrait nécessiter encore quelques années.

Il devra en effet être examiné par le Parlement européen puis par le Conseil, jusqu’à ce qu’un texte de compromis soit trouvé. Par comparaison, le RGPD a été adopté après 4 années de discussion.

En outre, comme pour le RGPD, un délai de 24 mois après son adoption est prévu par la proposition pour permettre aux acteurs de se mettre en conformité avant son entrée en application dans les États membres.

A suivre donc !

Et à l’étranger ?

À l’étranger, l’encadrement règlementaire de l’IA en est encore à ses débuts.

Par exemple, chez nos voisins Américains, quelques textes ont été adoptés pour réguler des aspects spécifiques de l’intelligence artificielle, tels que la reconnaissance faciale ou la transparence des objets connectés, mais il n’existe pas de cadre général.

La Chine a prévu d’établir un régime légal, éthique et stratégique pour l’intelligence artificielle d’ici 2025.

Au Canada, le Commissariat à la protection de la vie privée du Canada a publié en novembre dernier, ses recommandations en faveur d’un cadre réglementaire pour l’intelligence artificielle.